Chap.2 视频

Question-02:浅谈视频各常见名词

2.1 显示分辨率

连点成线,线多成面,其中的点就是像素。

像素:全称图像元素 Picture Element,是构成图像的最小单元。pix是picture的俚语,故化简为pixel,作为单位时写成px。

—分辨率标准

标清:Standard Definition(SD),狭义定义下标清是指640×480。

高清:High Definition(HD),高清包括1280px × 720px(横向有1280个像素,纵向有720个像素)。

480P:纵向分辨率为480px,即垂直像素点有480行。

720P:纵向分辨率为720px,即垂直像素点有720行。

1080P:纵向分辨率为1080px,即垂直像素点有1080行。

后面带P的只规定了行数,没有规定横向的像素点是多少。换句话说1080P不一定指1920×1080(16:9),1440×1080(4:3)也能叫1080P。

广义来说,720P和1080P都能叫高清。

全高清:Full High-Definition(FHD),即16:9的1080P—— 1920×1080。

超清:Super Definition(SD),能同时支持标清和高清的播放器(百度)。但是谷歌上面没有超清的定义,合理怀疑这个词是国人造出来的。

超高清:Ultra High-Definition(UHD),即4K(2160P)、8K(4320P)分辨率。

4K:3840 × 2160 = (1920 × 2) × (1080 × 2),即1080P各边的两倍。

8K:7680 × 4320 = (1920 × 4) × (1080 × 4),即1080P各边的四倍。

—D1~D5

简单介绍一下什么是D1,大家都以为D1是硬盘录像机显示、录像、回放的分辨率,实际上不是,D1是数字电视系统显示格式的标准,共分为以下五种规格:

D1:480i格式(525i),720×480(水平480线,隔行扫描),和NTSC模拟电视清晰相同,行频为15.25kHz,相当于我们所说的4CIF(720×576)。

D2:480p格式(525p),720×480(水平480线,逐行扫描),较D1隔行扫描要清晰不少,和逐行扫描DVD规格相同,行频为31.5kHz。

D3:1080i格式(1125i),1920×1080(水平1080线,隔行扫描),高清放送采用最多的一种分辨率,分辨率为1920×1080i/60Hz,行频为33.75kHz。

D4:720p格式(750p),1280×720(水平720线,逐行扫描),虽然分辨率比D3要低,但是因为逐行扫描,市面上更多人感觉1080i视觉效果更加清晰,分辨率为1280×720p/60Hz,行频为45kHz。

D5:1080p格式(1125p),1920×1080(水平1080线,逐行扫描),目前民用高清视频的最高标准,分辨率为1920×1080p/60Hz,行频为67.5kHz。

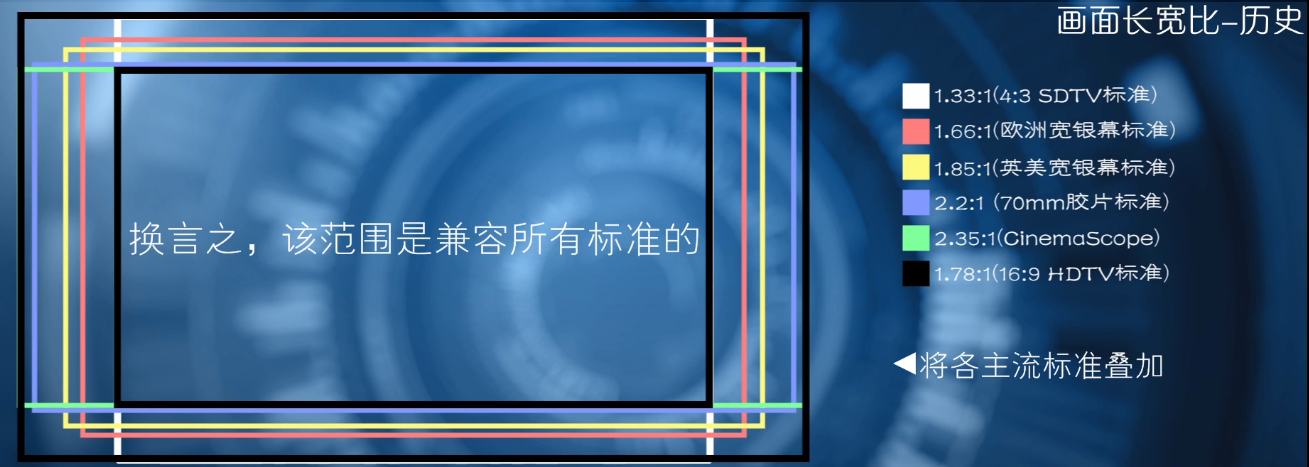

2.2 画面长宽比

长宽比:Aspect Ratio,也叫纵横比或者宽高比,顾名思义就是长与宽的比值,比如1280:720 = 16:9 $\approx$ 1.78。

—称呼方式(小数点/比值)

带小数点的是电影行业的称呼方式,而16:9、4:3这种称呼方式则是电视行业的标准。

关于16:9、4:3的由来历史,请自行百度谷歌,相关内容太长了而且不是特别重要,我这里就不写了!

2.3 帧、帧率和场

—帧、格、帧率

帧:Frame,其原意是画框、边框,视频中一个完全静止的图像称之为帧。视频是由连续的一系列帧组成并按照一定的顺序播放的,帧是视频的最小组成个体和单位。

以前,胶片的每一格就是一帧,把静态的连续画面进行播放能变成动态影像。要形成动态影像最低限度需要每秒播放8帧,而比较流畅的动态影像需要每秒12帧。

帧速率:Frame Per Second(FPS),简称帧率,即视频中每秒的图像帧数。比如,电影每秒有24个画面,帧速率就是24fps。一般来说,帧速率是由视频制式决定的。

—视觉暂留、闪烁感觉、临界闪烁频率(45.8Hz)

视觉暂留现象:Persistence of Vision 也叫视觉滞留现象。人眼在观察事物的时,光信号会进入我们的眼睛,我们才产生视觉从而看到东西。而光脉冲刺激人眼时,视神经对视觉需要一定的时间来建立和消失,这就是惰性。

人眼会有视觉暂留功能是为了补完画面。你试着把手掌摊开在眼睛面前晃,明明手确实遮住了屏幕的一部分但是我们还是可以看到手所遮住的内容,因为上一瞬间画面的视觉暂留,于是我们看到了完整的画面。

临界闪烁频率:45.8Hz是临界闪烁频率,换句话说,每秒钟要切换(闪)45.8次图象人眼才会觉得不闪。

电影胶片在进行放映的时候,用连续播放来“欺骗”观众说这不是静止图像,而为了“欺骗”观众觉得这个银幕没有闪,就会采用遮光器(blade-shutter)达到切换帧的效果。

因为45.8Hz是人眼觉得不闪的最低限度,所以16格是所有电影采用的最低选择(每一帧闪烁三次)。但是关系到音频的采样,24格是35mm胶片保证音频不失真的最短必要长度。

—高帧数画面

高帧:高帧数,比如60fps、120fps。

有人会说流畅的视频是高帧的,其实不然。将《化物语》作为例子,视频的帧速率可能都是相同的24帧,流畅是因为中间画多了。以前的动画很多逐帧画的,所以我们感觉非常流畅;但是现在的动画一般都是两帧一画面或者三帧一画面。所以流畅是因为中间画的张数多了,不是真的高帧。

原画:绘制关键动作,原画师的工作。

中割:绘制中间动作,动画师的工作。

一拍一:一帧一张画(流畅)

一拍二:两帧一张画

一拍三:三帧一张画(省钱)

—电视制式:PAL、NTSC、SECAM

电视制式:一个国家或地区播放节目时其电视信号所采用的标准。

三大制式:NTSC(源自美国,简称为N制)、PAL(源自西德,简称为P制)、SECAM(源自法国)

PAL与SECAM差不多,主要分辨前两者。

NTSC:National Television Standards Committee的缩写,(美国)国家电视标准委员会。简称N制。

PAL:Phase Alternating Line 逐行倒相,解决了N制的相位失真。简称P制。

N制还是P制,是由各国交流电频率所决定的,60Hz用N制,50Hz用P制。

—P制和N制的标准

| 制式 | 电视线 | 场数 | 场序 | 帧率 | 分辨率 |

|---|---|---|---|---|---|

| N制 | 525条 | 60场 | 先偶后奇 | 29.97 | 720 × 480 |

| P制 | 625条 | 50场 | 先奇后偶 | 25 | 720 × 576 |

—电视扫描线、场消隐、回扫线

线:在广播电视刚出现的时候,由于技术限制,没有分辨率的说法,只有清晰度一说,而且其判断标准就是电视扫描线。

电视扫描线:TvLine,简称电视线,也叫电视行,电视的画面清晰度以水平清晰度作为单位。

电视图像是由电子束一行一行扫描出来的,参考高中物理课本!

为什么是625条电视扫描线但是像素点只有576行?

因为场消影的缘故,回扫线占了50行。每扫一行,就需要回扫,回扫不传输画面,需要用场消影来消掉(虽然观众看不到,但是却是真是存在的),即625-50=575。而且最后一行不需要回扫,那么就是575+1=576行。

扫描方式一共两种:隔行扫描和逐行扫描。

—隔行扫描、逐行扫描

P:所谓720P、1080P之后的“P”表示Progressive,逐行扫描,是现在大多数的显示方式。

i:所谓1080i之后的“i”表示Interlaced,隔行扫描,隔一行扫描一次。这是为了在有限的带宽资源条件下提高图像刷新率。隔行扫描就是将一个静止画面分为两场进行扫描,所以一帧要扫描两次。

场:一幅画面扫两次,这两次的画面即为场。

P制:P制交流电频率是50Hz,但因为是逐行扫描,所以50场扫两次,就是50÷2=25(fps)

N制:为了避免信号和载波之间的相互干扰,以降频来显示彩色电视的信号保证其不受影响,降了场频本身的千分之一,所以60场变成了60-60×$\dfrac{1}{1000}$=59.94(场),因为隔行扫描,所以59.94÷2=29.97(fps)

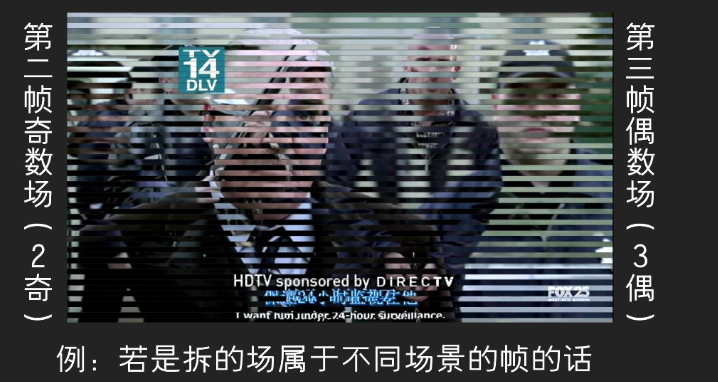

奇数场:Odd Field,也叫上场 Upper Field,或者顶场 Top Field。

偶数场:Even Field,也叫下场 Lower Field,或者底场 Bottom Field。

因为相邻的场在前期拍摄的时候就是交错的,无法完美的合在一起,所以当你用逐行扫描的显示器直接播放隔行扫描的视频会出现拉丝。

拉丝:Interlacing Artifacts,又叫拉线、交织等。

拉丝的解决办法当然是去交错。

去交错:Deinterlacing,有很多方法,一般播放器会自带的。

——若你导入素材遇到拉丝,将素材设为上场优先或下场优先

——若是导出视频遇到拉丝,将设置设为逐行扫描而非隔行扫描

上面讲得这些已经快过时了,因为美国和日本都将要不用N制了。因为P制和N制都是模拟电视时代的产物,现在已经进入数字电视时代,有了新标准。

—电影电视间帧率转换

为了将电影转化为P制信号,电视商将影片的播放速度调一下,硬是拖出来一帧(P制25帧,电影24帧)。

但是很显然N制不能这么干(N制30帧),只能使用3-2下位变换技术。这里就不细说这个技术的原理了,总之就是一种很坑爹的技术,而且会产生一个问题叫交错鬼影。

交错鬼影:Interlacing Artifacts, 因为3-2pull down技术将两个不同画面的奇数场与偶数场合并,合并出来的画面完全不能看的情况。

2.4 像素比

—像素长宽比

简称像素比 Pixel Aspect,表示每个像素的宽度和高度之比,设置像素比是为了使得摄像机拍摄出来的图像和在电视上播放的图像一样宽。如果你播放某些影碟或者在电视上看视频的时候发现画面被拉长一些,很多时候就是设置视频像素比的原因了。

像素点是长方形(以前是正方形),P制像素比是1.067:1,N制像素比是0.889:1。

—a1080

有些资源上面既标识1440×1080,又标上了16:9,为什么呢?因为这个资源的像素比是1.33:1,换言之1440 × 1.33 :1080 × 1 = 16:9。这种视频也叫a1080,a代指Pixel Aspect Ratio 像素宽高比。

2.5 码率

视频清晰度除了看画面分辨率、屏幕尺寸外,还有个码率。

码率:Bit Rate/Data Rate,又叫比特率/数据率/码流,即单位时间内传输的数据位数,说白了就是数据的传输速度。码率越大,每秒数据量越大,文件体积越大,音画质也越好,网放缓冲越慢,上传后转码的时间越长,观众看的越卡。

渣画质流畅:低码率

高画质卡顿:高码率

常用单位是Mbps/Kbps

—码率形式

码率有两种形式:

CBR:Constant Bit Rate 静态/常态/固定码率,整个视频全程统一码率,易导致码率浪费。

CBR 商业用、个人收藏用,音画质为第一要素。

VBR:Variable Bit Rate 动态/可变码率,会对码率合理分配。

VBR 网络传播用,同时兼顾画面质量和文件体积。

—“后黑”

后黑:视频后面加一段黑,以此降低码率来保证画质。虽然这段黑屏不一定有,但是进度条能够看出来。编码的时候,认为这段黑屏没细节就使劲压缩,直接拉低了整体码率水平,逃过了二次压制的命运。

可当作路程=时间x速度

路程没有变=内容&画质不变

时间拉长=后黑

结果速度下降=码率变低

—码率计算文件大小公式

码率可以用来估算文件大小:

文件大小 $\approx$ $\displaystyle\dfrac{码率 × 时长}{8}$

2.6 位深与色深

—色深、真彩色

色深:Color Depth 色深用2的指数来表示,一般是8bit、16bit和24bit。

真彩色:True Color 32bit 是人眼分辨的极限。

其实24bit就已经是真彩色了,而32bit给红、蓝、绿、透明通道(Alpha Channel)各8bit。

—透明通道、抠图/抠像

抠图/抠像:从一个完整的图片上扣出一部分叫作抠图,抠出一段视频叫作抠像。

透明通道:透明通道=255,不透明;透明通道=0,透明。

图片要保留透明通道用的最广泛的格式是PNG,视频一般用MOV。

JPG与PNG的区别:JPG是完全不带透明通道的,而PNG带。

PNG格式主要有两种:PNG-8和PNG-24,“8”指的是8bit(256色),“24”当然指的是24bit。

PNG-8和PNG-24的区别:PNG-8的透明通道只能是0或255这两个值,也就是说要么完全透明要么完全不透明;而PNG-24则有中间值,可以展现渐变透明的情况。

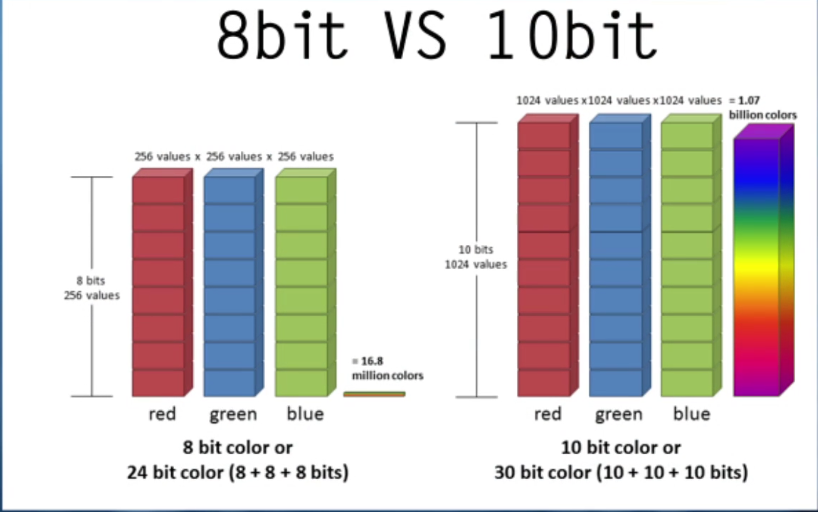

—位深

位深:Bit Depth 找资源经常可以看见8bit和10bit之类的。色深的每个通道都是8bit,那么它的位深就是8bit。而10bit则是以10bit为单位的通道衍生出来的。

简单地说,8bit、16bit、32bit都是色深,但是他们的位深,即Bit Depth都是8bit;而10bit的位深,它的色深都是10bit、20bit、30bit。

一个是单独通道的深度(位深),一个是整体色彩的深度(色深)。

—8bit VS 10bit

10bit视频和8bit视频之间的区别:

1)10bit无色带:10bit因为有更多的颜色,所以可以更好地处理色彩过度区域,8bit普遍处理不好。这个问题叫色带 Color Banding,也叫Banding Artifacts,一般出现在颜色过度区域那种渐变场景。

2)10bit防色块:10bit在暗场时处理比8bit好,画面暗下来的时候,8bit会有色块,分辨率低的时候色带也会变成色块。

3)10bit保细节:比起8bit可以在节省码率的情况下更合理地保留噪点,也即在实现更好画质时降低视频体积。压制时降噪过度会损失很多细节,更容易出现banding。防止banding又要保留噪点,但保留噪点又很费码率,而10bit可以很好地解决这个问题。

噪点:那些密密麻麻一般不仔细看不会看到的点,含有很多信息。

4)10bit高压缩:压缩比更加高,10bit因为编码复杂而耗时更长以外,其优势明显。

目前不普及的原因主要还是因为支持它的解码器不好办,目前10bit只有软解码,没有显卡能做到实际意义上的硬解码。如果上传到视频网站上在线观看,10bit视频的画面就像被加了一层绿色似的。导入视频软件的时候也经常出错,要么导不进去,要么画面变绿。所以现在传视频和做视频都是用8bit,如果仅供观看收藏用的话那可以考虑10bit。

Hi10P&Hi8P:10bit也叫Hi10P,全称High 10 Profile,基于10bit的H.264 High Profile编码。同理,Hi8P=8bit。

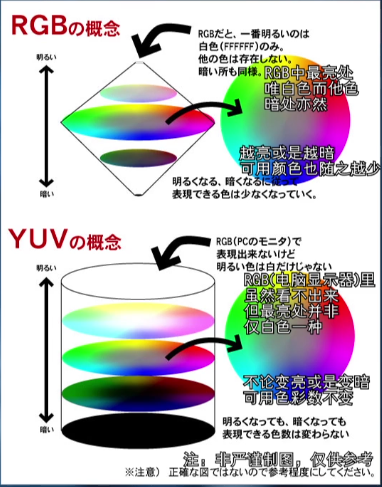

2.7 YUV

YUV后面加数字表示一种图像的采样格式。

—色彩空间

色彩空间:Color Space

色彩空间有很多种,比如RGB,是由颜色发光的原理来定的(加法混色),还有依据颜色反光来定的CMYK(减法混色),CMYK主要用于印刷。这里讲的YUV主要运用于电视上,是P制和塞康制用的。

—亮度信号和色度信号

Y信号:亮度信号,以前的黑白电视就只有Y这个信号,就是灰阶值。

亮度/明亮度/灰度 luminance/luma

U&V信号:色差信号,UV是颜色色差的两个分量,用来表示色度。

色差 color difference/chrominance/chroma

色度:包含了除了亮度的其他信息。

颜色是由亮度和色度共同表示的,但是两者没有交集。

色度三原色叠加会变成黑色,亮度三原色叠加成白色;色度是反光原理,亮度是光源。

YUV最大的特色是节省带宽,比RGB少很多。

—YCbCr/YPpbpr

U=B-Y,(blue蓝)-亮度,记作chroma blue Cb 蓝色色度

V=R-Y,(red红)-亮度,记作chroma red Cr 红色色度

这样出现了YCbCr,一般而言YUV就是YCbCr。

这里看不懂没关系,因为我也看不懂,根本不知道自己在写什么。

—YUV样式

YUV有四种采样格式:

YUV 4:4:4 统一频率进行完全采样,理论上画质最高,但是因为人眼的局限性,所以一般没有必要。

YUV 4:2:2 子采样格式,可以节省带宽的三分之一。

YUV 4:1:1

YUV 4:2:0